Obwohl viele Menschen Normen eher kritisch gegenüber stehen, dulden sie in ihrer Umgebung Normen, die nie jemand so gewollt hat oder gar nieder geschrieben. Eine der schlimmsten davon ist der „PC mit Windows“. Nie hat jemand gewollt, dass alle Benutzer einen Bildschirm auf einen Kasten stellen und beide auf den Tisch. Die Realität sieht anders aus. Dieser „Norm“ verdanken viele Menschen ihre Kopf- und Nackenschmerzen.

„PC mit Windows“ bedeutet auch, dass man eine riesige Tastatur und daneben eine Maus benutzt. An sich nichts schlimmes. Leider sind die Schultern aller Menschen schmaler als die Breite der Tastatur und daher muss jeder, der eine Maus „optimal“ benutzen will, seinen rechten Arm verrenken. „Mausarm“ als Symptom oder echte Erkrankung hat einen steile Karriereschub hinter, als Leidensweg noch vor sich. Die übliche Tastatur ist ein Relikt aus „mauslosen“ Zeiten.

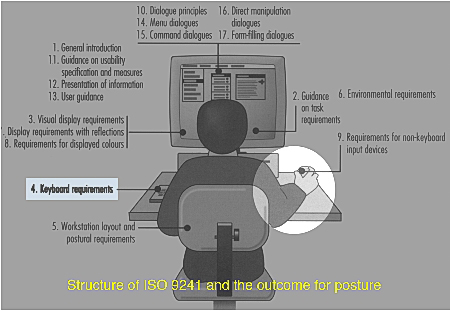

Was tun, wenn man das Arbeiten nicht verbieten will, obwohl sie für viele Menschen ungesund ist? Hier hilft die Norm DIN EN ISO 9241-410 „Ergonomie der Mensch-System-Interaktion – Teil 410: Gestaltungskriterien für physikalische Eingabegeräte“. Sie führte die „Kompakt-Tastatur“ als Standard für Bildschirmarbeitsplätze ein. Diese wurde außerdem ein Ebenbild der Laptop-Tastatur, für die es derzeit keine Norm gibt. Daher müssen sich Benutzer bei jedem Tastaturwechsel neu orientieren.

Von der Norm können die Benutzer daher doppelt profitieren. Auch Hersteller profitieren, weil sie die Tastaturen nicht doppelt herstellen bzw. vorrätig halten müssen. Es fehlen nur noch diejenigen, die die alte Tastatur mit dem Zehnerblock benötigen. Für diese gibt es zwei Lösungen: Die alte Tastatur weiterhin benutzen oder zu der Kompakt-Tastatur einen separaten Zehnerblock addieren. Von der zweiten Lösung profitieren gerade die hier angeführten Benutzer. Denn sie benötigen nicht alle und auch nicht immer die gesamte Tastatur, manchmal brauchen sie nur den Zehnerblock, manchmal nur den Schreibbereich und manchmal den Zehnerblock auf der linken Seite der Tastatur. Für all diese Fälle schafft DIN EN ISO 9241-410 Abhilfe.

Ob die Tastaturen dadurch billiger geworden sind, weil fast ein Viertel der Tasten entfallen sind, lässt sich nicht sagen. Auf jeden Fall wurde der Materialeinsatz um diesen Betrag kleiner. Bei 250 Millionen PCs im Jahr bestimmt keine Lappalie. Die Preise für Tastaturen werden seit langem nicht durch deren Herstellung bestimmt, sondern eher durch ihren Transport über die halbe Weltkugel.

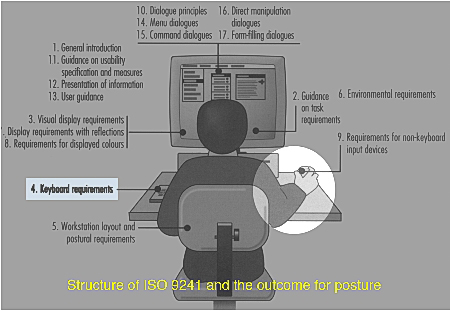

Mehr zu dem Thema Gesundheit und Mausarm sowie der Struktur der Normen insgesamt ist im Download Bereich angeführt.

zurück zu Normen für Bildschirmarbeit

Das ERGONOMIC Institut hat einen Großteil seiner Aktivitäten der Schaffung oder späteren Prüfung von technisierten bzw. hochtechnisierten Arbeitsverfahren gewidmet. Solche Aktivitäten stießen und stoßen häufig auf Skepsis, und zwar sowohl bei Befürwortern von Technik als auch bei ausgesprochenen Gegnern. Wer konnte an der Frage „Ist der Computer der Jobkiller oder Jobknüller?“ einfach vorbeigehen? Warum man solche Fragen lieber unbeantwortet lassen sollte, kann man anhand der Begriffe „Technik“ und „Technologie“ darstellen.

Während eifrige Verkäufer von technischen Produkten bereits simple Produkte zu einer Technologie hoch stilisieren, sprechen Industriesoziologen sehr selten von „Technologien“. Auch Ingenieuren und Technikern ist der Begriff Technologie zu hochtrabend. Sie reden lieber von Technik, allenfalls von „Engineeringsprodukten“, wenn sie sich wagen, etwas großspuriger zu reden. Das Wort Technologie, insbesondere dessen englische Form „technology“ ist typisch für Marketingssprech.

Die Inflation des Begriffs Technologie beraubt uns der Fähigkeit, zwischen purer Technik und hochwertigen technischen Systemen zu unterscheiden. Technikfeindlichkeit ebenso wie übertriebene Technikgläubigkeit sind häufig auf dieses fehlende Unterscheidungsvermögen zurückzuführen.

Durch eine viele Jahrzehnte alte Differenzierung lässt sich viel Verständnis für die Dinge schaffen, die sich um den Begriff Technik ranken. Diese besagt, dass es drei unterschiedliche Stufen von „Technologien“ gibt:

- technische Technologien

- intellektuelle Technologien

- soziale Technologien

Als Beispiel für eine technische Technologie kann man ein Mobilfunktelefon anführen. Ein solches Gerät besitzt für sich gesehen keinen Wert, solange es keine zweite Person mit einem Gerät gibt, das mit dem ersten kommunizieren kann. Zudem muss der Besitzer des ersten Geräts die Nummer des zweiten kennen. Üblicherweise nennt man solche Technologien schlicht „Technik“. Sie können weder Knüller noch Killer sein. Schon gar nicht von Jobs.

Aus einer solchen wertfreien Technik lässt sich eine „intellektuelle„, d.h. denkende bzw. durchdachte Technologie entwickeln, indem man sie mit bestimmten Zielen verknüpft, evtl. auch mit weiteren Techniken. Ein Beispiel hierfür wäre die Schaffung und der Betrieb einer Firma mit Hilfe von Mobilfunkgeräten und aus Menschen, die an verschiedenen Stellen der Welt leben (müssen). Als eine weitere Technik, die das gleiche Ziel unterstützt, kommt das Drucken in Frage, womit ein Verzeichnis der Mitarbeiter der Firma erstellt und verteilt wird.

Bereits diese Firma ist nicht mehr als wertfrei zu betrachten, weil sie gute wie böse Ziele verfolgen kann. Ihr wesentlicher Bestandteil muss auch nicht mehr die technische Technologie, d.h. das Mobilfunkgerät, sein. Die Technik liefert lediglich die notwendigen Voraussetzung für deren Funktionieren. In dieser Rolle ist auch sie nicht mehr wertfrei.

Wie eine technische Technologie der Entstehung solcher Gebilde beitragen kann, demonstriert z.B. die Nutzung von Handies unter Jugendlichen, die im Rahmen vieler (menschlicher) Netzwerke miteinander kommunizieren, einst hauptsächlich durch SMS, heute durch viele Medien und Apps. Die „Technologie“, die insbesondere Jugendliche in Europa entwickelt haben, hat nicht nur eine eigene Sprache hervorgebracht, sondern völlig neue Verhaltensweisen produziert. Diese Sprache hat z.T. mit der gesprochenen wenig zu tun, weil sie viel mit bildern (z.B. Emojis) arbeitet.

Den Gipfel von „Technologien“ bilden soziale Technologien, bei denen technische und intellektuelle Technologien bewusst verknüpft werden, um ein gemeinschaftliches Ziel zu erreichen. Beim Beispiel des Mobilfunktelefons wäre dies eine Organisation von Umweltschützern, die ihre Aktionen weltweit über Mobilfunknetze koordinieren. Solche Technologien sind weit davon entfernt, wertfrei zu sein. Sie stellen für manche Regierungen gar eine Existenzbedrohung dar, während andere ihre Existenz gerade solchen Netzwerken verdanken. Viele Menschen in Indien oder Afrika verdanken ihr Leben dem „Handy“, dem der medizinischen und sozialen Betreuer, deren Arbeit vor Ort im entferntesten Dorf in steter Verbindung mit den Ressourcen in großen Ballungszentren (Ärzte, Apotheker, Krankenhäuser) ablaufen kann. Menschen, denen keine Bank ein Konto einrichten würde, weil der Umsatz mickrig wäre, können über ein Smartphone Geldgeschäfte führen und sind so nicht von der wohlhabenderen Bevölkerung abgekoppelt.

Es hat sich als sinnlos erwiesen, sich für oder gegen „technische“ Technologien zu stellen, weil diese eben wertfrei sind. Hingegen kann man nachweisen, dass man die hierzu vergeudete Zeit und Kraft eher hätte aufwenden sollen, um unerwünschte Anwendungen solcher Techniken zu behindern und die wünschenswerten zu fördern. Einen überzeugenderen Nachweis für diese Vorstellung als die Führerschaft der skandinavischen Länder in der Computereinführung bzw. -durchdringung wird es vermutlich nicht geben. Dort agierten über Jahrzehnte die schärfsten Kritiker der Computertechnik. Sie haben geholfen, computergestützte Technologien zu schaffen, die wiederum den Wohlstand in diesen Ländern wirkungsvoll unterstützen. Während man in Deutschland der 1980er Jahre und danach fürchtete, durch die Computer arbeitslos zu werden oder hohen Belastungen bei den übrig gebliebenen Jobs ausgesetzt zu werden, gehören die Bürger der nordischen Länder im 21. Jahrhundert zu den glücklichsten Menschen auf dem Planeten.

Ob sie etwas Neues darstellen oder die Vervollkommnung von vorhandenen Technologien, die semantischen Technologien, wird sich noch herausstellen (siehe, leider keine Quelle i.S. eines Semantic Web). Ob man Dinge, die nicht nur Hilfsmittel oder Werkzeuge darstellen, um ein begrenztes Ziel zu erreichen, z.B. wie Werkzeuge und Maschinen, sondern das Verhalten von Menschen, Gruppen bis hin zu Völkern ändern, mit dem Uralt-Begriff Technologie bezeichnen sollte, sei dahingestellt.

zurück zu: INFOS

Lernziel

- Vermitteln von Grundkenntnissen der MMI (Grundmodelle der MMI, softwareergonomische Gütekriterien der Benutzerfreundlichkeit, Grundlagen menschlicher Informationsverarbeitung).

- Vermitteln von Grundkenntnissen einer ganzheitlichen und durchgängigen ergonomischen Unterstützung von Entwicklungsprojekten (Benutzerpartizipation, Benutzerprofilanalyse, kontextuelle Aufgabenanalyse, Usability-Ziele, Gestaltungsprinzipien (Farbe, Symbolik, Gruppierung, Anordnung, …), Usability-Testing mit Videoeinsatz, Styleguides, …).

- Veranschaulichung der Grundkenntnisse anhand praktischer Beispiele aus der Industrie.

- Vertiefung der Grundkenntnisse durch praktische Übungen.

Weitere Informationen

Benutzungsoberflächen und Bedienschnittstellen haben in heutigen IT-Systemen einen hohen Stellenwert. Da es sich hier oft um Arbeitsplatzsysteme handelt, an denen Menschen mit Hilfe eines Dialogsystems Aufgaben zu bearbeiten haben, spielt die Betrachtung (software-) ergonomischer Aspekte bei der Entwicklung und Gestaltung der Dialogsysteme eine große Rolle.

Die Vorlesung Usability Engineering gibt eine Einführung in die Grundlagen der Mensch-Maschine-Interaktion (MMI). Ferner vermittelt sie tiefere Einblicke in Konzepte, Methoden und Werkzeuge einer ganzheitlichen, durchgängigen und ingenieursmäßigen ergonomischen Unterstützung von Systementwicklungsprojekten. Dabei wird auf alle relevanten Phasen der Systementwicklung aus Sicht der Ergonomie eingegangen (Projektmanagement, Anforderungsanalyse, Entwurf, Integration, Überleitung in die Nutzung). Die Inhalte stützen sich auf ein Vorgehen gemäß Usability Engineering, welches in der wissenschaftlichen Welt etabliert ist und in der DaimlerChrysler-Forschung Software-Technologie weiterentwickelt und erprobt wird.

zurück zu: Vorlesungen und Kurse zu Usability aus Deutschland

Angebot Uni Konstanz

Projektpraktikum (BA) Human-Computer Interaction

Practical cooperative course (BSc) Human-Computer Interaction

(P4)

Vorbesprechungstermin: nach Bekanntgabe

Doz.: Harald Reiterer, Mitarbeiter

Themengebiet: Angewandte Informatik / Informationswissenschaft

Adressaten:

Studierende des Information Engineering im Bachelor-Vertiefungsstudium (Projektpraktikum) bzw. im Masterprogramm (Praktikum)

Angebot im Lehrexport:

* Lehramt, Zusatzfach Informatik

* Mathematik, Nebenfach oder Schwerpunkt Informatik

Voraussetzungen:

Grundlage in Mensch-Computer Interaktion. Kontaktieren Sie Prof. Reiterer (Mentorengespräch) um herauszufinden, welche weiterführenden Kurse besucht werden sollten („praktikumsbegleitende Lehrveranstaltungen“).

Inhalt:

Dieses Projekt bietet den Studenten die Möglichkeit über einen Zeitraum von zwei Semestern am selben Thema (z.B. vollständige Evaluation eines interaktiven Systems; Design und Entwicklung einer speziellen Art eines interaktiven Systems; Entwicklung von neuartigen Visualisierungen) zu arbeiten. Die Projekte sind typischerweise eingebettet in aktuelle Forschungsprojekte der Arbeitsgruppe HCI (z.B. laufendes EU-Forschungsprojekt INVISIP oder Projekte mit Industriepartnern wie der DaimlerChrysler AG, Ulm). Hierbei können die Studenten eigene Arbeiten zu den Forschungsprojekten beisteuern. Es wird Gebrauch gemacht von den neusten Methoden und Techniken im Bereich MCI und Informationsvisualisierung. Die Studenten lernen außerdem unter realistischen Projektbedingungen zu arbeiten (z.B. Erstellen eines Projektplans, Einhalten von Meilensteinen, regelmäßige Präsentationen, Teilnahme an Meetings zur Überprüfung der Arbeit), was eine wichtige Erfahrung für die zukünftige professionelle Arbeit ist.

Mehr Information über aktuelle Forschungsprojekte der Arbeitsgruppe HCI finden sich auf der Seite http://www.inf.uni-konstanz.de/iw_is/Forschung/index.html.de

Literatur:

* Wird abhängig vom jeweiligen Projekt bekannt gegeben.

Leistungsnachweis:

* Wird erreicht durch Abgabe der Bachelor-Abschlussarbeit.

Leistungspunkte:

* Bei erfolgreicher Teilnahme am Kurs können 2x 6 ECTS-Punkte erreicht werden.

<< zurück zu: Vorlesungen

Human-Computer Interaction, M.Sc.

Studieninhalte

Der internationale Studiengang basiert auf zwei grundlegenden Säulen:

Das Studium einer Auswahl aktueller Themen aus dem Bereich Human-Computer Interaction: Usability, User Centered Design, User Interface Testing & Forschung, neuartige Interface-Technologien wie Virtual Reality, Mobile Systeme, Adaptive Systeme, Mixed Reality, Ubiquitous Computing, grafische Interfaces

Das Vermitteln von Schlüsselqualifikationen durch einen projektbasierten Studienansatz in kleinen Gruppen zur Weiterentwicklung der wissenschaftlichen Kommunikations-, Präsentations- und schriftlichen Ausdrucksfähigkeit.

Detailliertere Informationen zum Curriculum finden Sie hier.

Der forschungsorientierte Master-Studiengang wird von international renommierten Professoren getragen, die wissenschaftlich ausgewiesen sowie national und international engagiert sind:

Prof. Bernd Fröhlich (Gewinner des Virtual-Reality Technical Achievement Awards, Mitbegründer des IEEE Symposium on 3D User Interfaces)

Prof. Eva Hornecker (Expertin in den Bereichen innovative Mensch-Computer Interaktionskonzepte, User-Centred Design und Museumsinstallationen; Mitbegründerin der internationalen Tagungsreihe ‚Tangible Embedded and Embodied Interaction‘; wieder in Deutschland nach 8jährigem Aufenthalt in UK und Neuseeland)

Prof. Sven Bertel (kehrte gerade zurück von einer zwei-jährigen Post-Doc-Stelle am berühmten Beckman Institute for Advanced Science and Technology, Human Factors Division, University of Illinois at Urbana-Champaign).

Prof. Florian Echtler (Experte für Tangible und Multi-touch Interaktion, ab Oktober 2014)

Prof. Charles Wüthrich (Enge Kooperation mit einer bildungsnahen TV-Produktions-Firma)

Prof. Volker Rodehorst (anerkannter Experte in den Bereichen Computer Vision und Photogrammetrie)

Ansprechpartner : Prof. Dr. Eva Hornecker eva.hornecker[at]uni-weimar.de

zurück zu: Vorlesungen

__ Bauhaus Universität Weimar bietet HCI als Master-Studiengang an. Das Studium „Human-Computer Interaction“ an der staatlichen „Uni Weimar“ hat eine Regelstudienzeit von 4 Semestern und endet mit dem Abschluss „Master of Science“. Der Standort des Studiums ist Weimar. Das Studium wird als Vollzeitstudium angeboten.

Fachstudienberatung – Human-Computer Interaction, Master of Science

>> mehr Informationen zu: Lehrangebot Uni Weimar https://www.studycheck.de/studium/mensch-computer-interaktion/uni-weimar-18839

__ An der Universität Konstanz bietet die Gruppe Human Computer Interaction Group eine Reihe von Aktivitäten zu Human Computer Interaction (HCI) an.

>> mehr Informationen zu: https://hci.uni-konstanz.de/

__ UNI Ulm (Institut für Medieniformatik, Team Human Computer Interaction, Prof. Enrico Rukzio ) bietet Lehre und Forschung zu HCI (Anwendung z.B. in der Unterhaltungselektronik, in Fahrerassistenzsystemen, sowie bei der Auswertung wissenschaftlicher Daten in Gebieten wie der Archäologie, der Biologie und der Medizin.

>> mehr Informationen zu: https://www.uni-ulm.de/in/mi/

__ An der FH Potsdam kann man UX studieren (Interfacedesign (B. A.) – User Experience (UX) & User Interface (UI) Design.

>> mehr Informationen zu: FH Potsdam Fachbereich Design https://shorturl.at/bfH15

Die nachfolgend angeführten Links führen zu Informationsangeboten, die sich mit Usability bzw. Gebrauchstauglichkeit beschäftigen. Bei den neuesten Angeboten steht meistens UX (user experience) dahinter.

__ Zum Thema Usability werden an vielen deutschen Universitäten und Fachhochschulen Vorlesungen angeboten. Häufig werden die Inhalte zum Download angeboten.

>> mehr Informationen zu: Vorlesungen und Kurse zu Usability

__ Deutsche Usability Professionals haben sich nach dem Vorbild der USA zu einem Berufsverband zusammen geschlossen. Sie unterhalten mehrere Diskussionsforen zum Thema und eine Jobbörse.

>> mehr Informationen zu: Quellen für Usability Information

Das Usability Konzept wurde in einem Projekt für Software-Ergonomie niedergeschrieben. Es lässt sich aber vorzüglich auf Konsumgüter anwenden. Designer von Alltagsgegenständen haben das Konzept sinngemäß angewendet, noch bevor es genormt wurde. Leider geschah dies eher intuitiv denn methodisch. Dies führt zum einen dazu, dass der Hersteller wenig von erfolglosen Produkten lernt. Und zum anderen, dass manchmal erfolgreiche Produkte verschlimmbessert werden, weil man häufig nicht weiß, weswegen ein Produkt erfolgreich geworden ist.

Das Usability Konzept wurde in einem Projekt für Software-Ergonomie niedergeschrieben. Es lässt sich aber vorzüglich auf Konsumgüter anwenden. Designer von Alltagsgegenständen haben das Konzept sinngemäß angewendet, noch bevor es genormt wurde. Leider geschah dies eher intuitiv denn methodisch. Dies führt zum einen dazu, dass der Hersteller wenig von erfolglosen Produkten lernt. Und zum anderen, dass manchmal erfolgreiche Produkte verschlimmbessert werden, weil man häufig nicht weiß, weswegen ein Produkt erfolgreich geworden ist.

Mit diesem Konzept können wir sowohl den Erfolg von geplanten Produkten, als auch die Gründe für einen Misserfolg nachweislich mit großer Sicherheit vorhersagen. Voraussetzung für eine Vorhersage von Erfolg ist allerdings, dass zumindest einige funktionelle Eigenschaften des Produkts für den Kunden wichtig sind. Produkte, bei denen der Spaßfaktor ausschlaggebend ist, lassen sich mit anderen Methoden besser bewerten.

Mögliche Eigenschaften, die zu einem Misserfolg führen können, lassen sich auch dann zuverlässig bewerten, wenn die Funktionalität nebensächlich ist. Auch bei einem eingetretenen Erfolg bzw. Misserfolg lassen sich die hierfür maßgeblichen Eigenschaften bestimmen, damit man sie bei weiteren Produkten beibehält.

Von uns geprüfte Produkte des täglichen Lebens waren u.a. ein intelligentes Bügeleisen, diverse Arbeitsplatzleuchten, eine Vielzahl von Computermonitoren, Bürodrehstühle, Fussstützen u.ä.

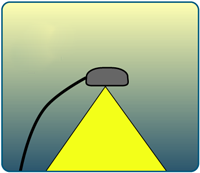

Die historisch älteste Form der künstlichen Beleuchtung sollte möglichst aus dem Gedächtnis der arbeitenden Menschen verschwinden. Man hatte etwa 1970 das seit mehr als 40 Jahren angestrebte Ziel erreicht, alle Arbeitsstätten gleichmäßig zu beleuchten – egal ob deren Benutzer dies wollten oder nicht. „Allgemeinbeleuchtung erhöht die Leistungsfähigkeit des Arbeiters“ hatte es zu Beginn des vergangenen Jahrhunderts geheißen. Zu dessen Ende glaubten die meisten Lichttechniker immer noch daran, auch wenn der Nachweis niemandem gelingen wollte.

Die historisch älteste Form der künstlichen Beleuchtung sollte möglichst aus dem Gedächtnis der arbeitenden Menschen verschwinden. Man hatte etwa 1970 das seit mehr als 40 Jahren angestrebte Ziel erreicht, alle Arbeitsstätten gleichmäßig zu beleuchten – egal ob deren Benutzer dies wollten oder nicht. „Allgemeinbeleuchtung erhöht die Leistungsfähigkeit des Arbeiters“ hatte es zu Beginn des vergangenen Jahrhunderts geheißen. Zu dessen Ende glaubten die meisten Lichttechniker immer noch daran, auch wenn der Nachweis niemandem gelingen wollte.

Nach dem Motto „Vom Guten kann man nicht zu viel bekommen“ hat man in den jüngsten Beleuchtungsnormen die Beleuchtungsstärken kräftig aufgestockt. Für die meisten Räume müsste man jetzt mindestens 50% mehr Licht installieren, für andere sogar 90% und noch viel mehr. Auch dort, wo mehr Licht das Sehen verschlechtert, in Schaltwarten, soll doppelt so viel Licht installiert werden wie man noch vor zwei Jahren hätte machen sollen. Energie kostet ja nix!

Licht kann man intelligenter zum Sehobjekt führen: mit einer Arbeitsplatzleuchte. Sie findet man überall dort, wo das Sehobjekt mehr Licht benötigt als der Raum, am Zeichentisch, an der Drehbank, in der Küche … und das mindestens seit 75 Jahren. Wir haben etwa 20 Jahre daran gearbeitet, dass aus der „Tischlampe“ ein genormtes Industrieprodukt wurde, das für den individuellen Lichtgenuss steht.

Während die übliche Tischlampe ihr Licht schlecht kontrolliert in die Umgebung streut, leuchtet die Arbeitsplatzleuchte nach DIN 5035-8 den vom Benutzer gewünschten Teil aus, schont aber die Augen des Tischnachbarn ebenso wie den Bildschirm, auf dem sie keine Reflexionen verursachen darf. DIN 5035-8 steht auch als Beispiel dafür, wie man durch Normung Individualität schafft und das auch in engen Arbeitsräumen.

Während die übliche Tischlampe ihr Licht schlecht kontrolliert in die Umgebung streut, leuchtet die Arbeitsplatzleuchte nach DIN 5035-8 den vom Benutzer gewünschten Teil aus, schont aber die Augen des Tischnachbarn ebenso wie den Bildschirm, auf dem sie keine Reflexionen verursachen darf. DIN 5035-8 steht auch als Beispiel dafür, wie man durch Normung Individualität schafft und das auch in engen Arbeitsräumen.

Nicht nur das. In der Corona-Zeit, als die meisten Menschen Hals über Kopf ins Homeoffice mussten, hat man den Wert einer Leuchte erkannt, die als Produkt genormt wurde. In Unterschied dazu werden Leuchten vom Hersteller als Komponenten (Bauprodukte) angeboten. Für eine Beleuchtung muss der Planer diese zweckmäßig aussuchen und installieren (lassen). D.h., im Prinzip ist der Hersteller einer Beleuchtung nicht der Leiuchtenanbieter sondern der Planer. Nicht so bei Arbeitsplatzleuchten nach DIN 5035-8. Wer ein solches Produkt kauft bekommt nicht nur ein gebrauchsfertiges Objekt, sondern auch eine Anleitung dafür, wie man es zweckmäßig einsetzt und einstellt.

Die Idee einer Norm für Arbeitsplatzleuchten wurden vom Ergonomic Institut entwickelt, gegen die Politik der Hersteller durchgesetzt. Bei der ersten Ausgabe der Norm im Jahr 1994 haben wir auch den Editor gestellt.

zurück zu: Erreichte Ziele

Die vom Präsidenten Jimmy Carter angeordnete Überprüfung US-amerikanischer Kernkraftwerke nach der Katastrophe von Three Mile Island hatte noch katastrophalere Mängel in der Ergonomie an den Tag gefördert, die den Unfall verursacht hatten. Die Kraftwerke in den USA wurden eiligst „ertüchtigt“. In anderen Ländern haben die Regierungen gewisse Auflagen an die Betreiber gemacht, aber mit zunehmender Entfernung vom Ort des Geschehens nahm die Bereitschaft ab, sich von der Vorstellung zu befreien, „so etwas kann bei uns nicht passieren“. Und das, obwohl in Three Mile Island fünf Vorfälle mit einer Wahrscheinlichkeit von jeweils 1/10.000 Jahren gleichzeitig aufgetreten waren. D.h., dass dieser Unfall theoretisch eine Wahrscheinlichkeit von einer Billion Jahren hatte. Da das Universum nur wenige Milliarden Jahre alt ist, hätte der Unfall eigentlich nicht passieren dürfen.

Die vom Präsidenten Jimmy Carter angeordnete Überprüfung US-amerikanischer Kernkraftwerke nach der Katastrophe von Three Mile Island hatte noch katastrophalere Mängel in der Ergonomie an den Tag gefördert, die den Unfall verursacht hatten. Die Kraftwerke in den USA wurden eiligst „ertüchtigt“. In anderen Ländern haben die Regierungen gewisse Auflagen an die Betreiber gemacht, aber mit zunehmender Entfernung vom Ort des Geschehens nahm die Bereitschaft ab, sich von der Vorstellung zu befreien, „so etwas kann bei uns nicht passieren“. Und das, obwohl in Three Mile Island fünf Vorfälle mit einer Wahrscheinlichkeit von jeweils 1/10.000 Jahren gleichzeitig aufgetreten waren. D.h., dass dieser Unfall theoretisch eine Wahrscheinlichkeit von einer Billion Jahren hatte. Da das Universum nur wenige Milliarden Jahre alt ist, hätte der Unfall eigentlich nicht passieren dürfen.

Nach der noch größeren Katastrophe von Tschernobyl haben wir eine Überprüfung der Kernkraftwerke in Deutschland angeregt. Das Land Nordrhein-Westfalen hat nicht nur die Ergonomie, sondern alle Eigenschaften der dortigen kerntechnischen Anlagen durchführen lassen. Die Ergebnisse sind leider nicht öffentlich verfügbar.

Unser Projektteil war so erfolgreich, dass wir später an der Arbeit der Reaktor-Sicherheitskommission beteiligt wurden. Ein Ergebnis dieser Arbeit ist eine ergonomische Prüfliste für Warten von Kernkraftwerken. Ein anderes ist die Einrichtung von anlagenspezifischen Simulatoren, die wir als erste Institution vorgeschlagen haben. Obwohl in den USA üblich, hielt man sie in Deutschland früher nicht für notwendig, weil man glaubte, dass die Mannschaften so qualifiziert wären, dass sie das Erlernte von einem unspezifischen Simulator auf ihre eigene Anlage übertragen würden. Und das im Falle einer echten Katastrophe! Und bei abgeschalteten Computern, denn sie gelten als unsicher.

Eine weitere Idee, für die die Fachleute der Kerntechnik einst nichts weiter als ein Lachen übrig hatten, periodische Sicherheitsüberprüfungen (PSÜ), wurden auch von uns Mitte der 1980er Jahre thematisiert. Diese Vorstellung passte überhaupt nicht mit der Denke zusammen, dass etwas, was einmal als sicher geprüft und genehmigt worden ist, unsicher werden kann. Zwar stellen Inspektion und Wartung eine der Säulen der Ingenieurstechnik und wurden selbstverständlich stetig durchgeführt und einmal jährlich als Revision ausgeführt und geprüft. Die Reaktor-Sicherheitskommission (RSK) empfahl in einer Empfehlung vom 23. November 1988, dass AKW alle zehn Jahre einer umfassenden Prüfung unterzogen werden sollten. Diese Prüfung sollte den aktuellen Sicherheitsstatus der Anlage überprüfen und sicherstellen, dass sie weiterhin den Anforderungen entspricht.

Die Rolle dieser Prüfungen wird vom BUMV im Jahr 2023 so dargestellt: „Die Periodischen Sicherheitsüberprüfungen (PSÜ) dienen dazu, ergänzend zu den laufenden Kontrollen insgesamt ein AKW quasi auf Herz und Nieren zu prüfen. Es sind ganzheitliche Prüfungen, deren Blickwinkel über die Prüfungen im regulären AKW-Betrieb hinausgehen. Die regelmäßigen Kontrollen nach dem Prüfhandbuch (Wiederkehrende Prüfungen = WKP) überprüfen lediglich, ob die geltenden technischen Anforderungen erfüllt werden. Die PSÜ überprüfen darüber hinaus, ob sich aus dem Erkenntnisfortschritt weitere Sicherheitsanforderungen ergeben und wie diese durch Nachrüstungen zu erfüllen sind.“

Mittlerweile sind zwar die deutschen AKW vom Netz gegangen, aber auch in der Diskussion um deren Wiederinbetriebnahme spielt PSÜ eine große Rolle.

zurück zu: Erreichte Ziele

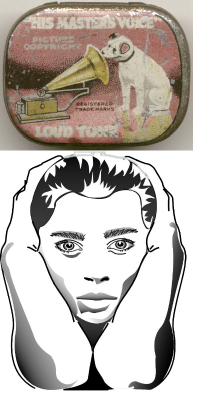

Das Forschungsprojekt „Arbeitsplätze für Phonotypistinnen“, veröffentlicht im Jahre 1983, hat neben vielen anderen Erkenntnissen ein sich unglaubwürdig anmutendes Ergebnis erbracht: Die harmlos aussehenden Diktiergeräte erzeugten Lärmpegel, die sich mit denen von Düsenjägern messen lassen. Das Ergebnis klang deswegen so unglaubwürdig, weil die Geräte mittlerweile über 80 Jahre im Einsatz waren und niemand sich darüber beschwert haben sollte. Zudem musste man in Zweifel ziehen, ob eine Elektronik mit einem geringen Energieverbrauch solche Lärmpegel hätte überhaupt erzeugen könnte.

Das Forschungsprojekt „Arbeitsplätze für Phonotypistinnen“, veröffentlicht im Jahre 1983, hat neben vielen anderen Erkenntnissen ein sich unglaubwürdig anmutendes Ergebnis erbracht: Die harmlos aussehenden Diktiergeräte erzeugten Lärmpegel, die sich mit denen von Düsenjägern messen lassen. Das Ergebnis klang deswegen so unglaubwürdig, weil die Geräte mittlerweile über 80 Jahre im Einsatz waren und niemand sich darüber beschwert haben sollte. Zudem musste man in Zweifel ziehen, ob eine Elektronik mit einem geringen Energieverbrauch solche Lärmpegel hätte überhaupt erzeugen könnte.

Sie kann! Der Kopfhörer eines Diktiergeräts verteilt ihre Energie nicht in die weite Welt, er steckt direkt im Ohr. Der Lärm, den er produziert, ist sogar gefährlicher als der, den der Düsenjäger verursacht, weil das Ohr zusätzlich mechanisch belastet wird. So war er nicht verwunderlich, dass 8 von 13 Phonotypistinnen in unseren Versuchen Hörschäden aufwiesen. Wenn es nur dabei geblieben wäre! Der mit dem erschwerten Hörvorgang verbundene Stress ging buchstäblich in den Rücken: Phonotypistinnen, denen die Arbeitsmediziner eine für Schreibkräfte ideale Körperhaltung bescheinigten, hatten mehr Rückenprobleme als Kolleginnen, die vom Blatt abtippten.

Die Sache wurde nicht ernst genommen, bis ein Mitarbeiter einer Berufsgenossenschaft eine Schätzung veröffentlichte, wonach ca. 300.000 Frauen allein in Deutschland gefährdet waren. Erst danach wurden Pegel-begrenzte Diktiergeräte entwickelt und eingesetzt. Mittlerweile sind viele neue Geräte mit Kopfhörern auf den Markt gekommen, die man nicht mehr beruflich benutzt. Sie erzeugen wieder so hohe Pegel wie 1983, mit Musik, die Freude macht. Die schöne Musik schützt einen aber nicht vor dem Schaden. Über den Witz „Opa, sprich lauter, ich verstehe dich nicht!“ kann man wirklich nicht lachen.

Man kann den hier skizzierten Vorgang nicht zu den Erfolgsgeschichten der Ergonomie zählen. Er stellt eher Teil einer fast ein Jahrhundert andauernden schwerwiegenden Ignoranz einer gesundheitlichen Schädigung dar. Der Vorgang begann mit einer der wichtigsten technischen Erfindungen der Geschichte, der des Phonographen. Dieser sollte nach dem Willen des Erfinders, Thomas A. Edison, der Kommunikation zwischen Chef und Sekretärin dienen.

Würde die Erfindung wirklich im Sinne des Erfinders genutzt werden, wäre damit kein nennenswertes Problem für die Benutzerinnen verbunden. Denn laute Geräte muss man nicht laut betreiben. Man hat das Gerät aber auch in zentralisierten Schreibstuben für Schreibkräfte eingesetzt. Dort herrschten um das Jahr 1900 wie 1980 Schallpegel über 75 dB(A), die die Benutzerinnen zwangen, ihre Geräte lauter aufzudrehen. Ihre Empfindung, nach der Arbeit fühlten sie eine Leere im Kopf, bereits beschrieben im Jahre 1912, gab allenfalls Anlass zu hämischen Bemerkungen über ihre Frisuren. Dabei hatten sie die Symptome einer Vertäubung beschrieben.

Im Jahre 1976, als die Probleme bereits erkennbar waren, allerdings noch nicht veröffentlicht, hat der Bundesrechnungshof allen Obersten Bundesbehörden vorgegeben, ihre Schreibkräfte zu zentralisieren und die Kommunikation mit den Sachbearbeitern nur über Diktiergeräte zuzulassen. So sollte die Schreibguterstellung im öffentlichen Dienst rationalisiert werden. Daran wurde festgehalten, auch nachdem die Erkenntnisse dieser Studie veröffentlicht worden waren.

Die zentralen Schreibdienste haben sich zum Glück weitgehend selbst aufgelöst, nachdem ein Projekt mit unserer Beteiligung (Schreibdienste in Obersten Bundesbehörden) zu der Empfehlung geführt hatte, nicht nur die Schreibdienste aufzulösen, sondern auch die Schreibarbeit weitgehend abzuschaffen. Aber ihre modernen Nachfahren der „zentralen“ Dienste, die Call Center, litten und leiden unter akustischen Problemen, die man vermeiden kann, wenn die Agenten nicht verdichtet zusammen gesetzt werden. Der Unsinn aus der Zeit der Schreibstuben und der späteren zentralen Schreibdienste wurde aber wiederholt, obwohl heute nicht einmal zwei Call Center Agenten auf dem gleichen Kontinent sein müssen, um effektiv arbeiten zu können. Sie sitzen aber noch dichter zusammen als zur Zeit der Telefonauskunft vor der Einführung der Computer. Zum Glück hatten die Call Center noch viele andere Mängel, so dass ihre Rolle heute sehr eingeschränkt ist.

Und obwohl Pegel begrenzte Kopfhörer bereits lange existieren, ruinieren sich viele Menschen ihr Gehör freiwillig. Manche auch unfreiwillig, wenn sie schlechte akustische Bedingungen versuchen durch Lautstärke zu übertönen.

Der Phonograph ist mit Sicherheit ein hervorragendes Beispiel dafür, dass nicht eine Technik eine Gefahr darstellt, sondern deren Nutzung. Er ist auch ein Beispiel dafür, dass eine gute Technik, falsch benutzt, ins Abseits geraten kann. Den Begriff Phonotypistin kennt heute kaum noch jemand.

zurück zu: Erreichte Ziele

Hersteller versuchen, den Kunden an sich zu binden, indem sie Produkte möglichst so konstruieren, dass Ersatzteile von anderen Herstellern nicht dazu passen. Die Idee ist nicht neu – und die Aussage stammt aus einem Buch von 1926, das die Gründung des DIN rechtfertigt. Trotzdem muss man sich auch heute solchen Versuchen erwehren. Die Welt hat sich verändert, bestimmte Praktiken sind geblieben.

Hersteller versuchen, den Kunden an sich zu binden, indem sie Produkte möglichst so konstruieren, dass Ersatzteile von anderen Herstellern nicht dazu passen. Die Idee ist nicht neu – und die Aussage stammt aus einem Buch von 1926, das die Gründung des DIN rechtfertigt. Trotzdem muss man sich auch heute solchen Versuchen erwehren. Die Welt hat sich verändert, bestimmte Praktiken sind geblieben.

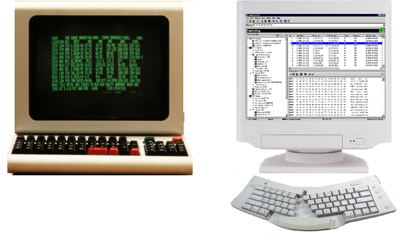

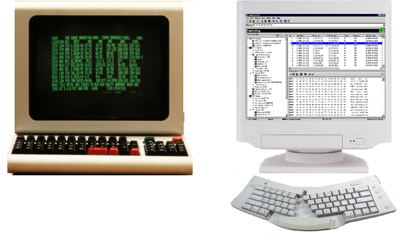

Bis zum Jahre 1987 haben sich Computerhersteller hinter technischen Barrieren verschanzt, die anderen Herstellern möglichst große Schwierigkeiten bereiten sollten, ihre Kunden zu beliefern. Bei dem hier abgebildeten Beispiel sollte ein großer Anwender gezwungen werden, nur das abgebildete Gerät zu benutzen und alle Benutzer zu veranlassen, ihre Körperhaltung von der Elektronik bestimmen zu lassen, die angeblich nur so wie abgebildet funktionieren wurde.

Wir haben nicht nur dem Anwender und seiner Personalvertretung helfen können, eine von ihnen akzeptierbare Lösung zu finden. Mit dem von uns entwickelten Konzept „Einheitliche Benutzungsoberfläche“ wurde durchgesetzt, dass kein Arbeitsmittel, das der Mitbestimmung unterliegt, mit der Wahl des Computersystems zwingend vorbestimmt sein darf. Da der Kunde einer der größten Anwender in Deutschland war, waren die technischen Barrieren plötzlich nicht mehr vorhanden. Dieser Kunde hatte vor 50.000 Terminals und die entsprechenden Großrechner zu kaufen.

So geben seit dem Jahre 1987 Computersysteme nicht mehr vor, welcher Monitor an welchen Rechner angeschlossen werden muss. Nur die Aufgabe ist dafür maßgeblich – leider manchmal auch die Kosten. Allerdings haben diese sich durch den technischen Fortschritt marginalisiert. Seit langem gibt es 4K-Monitore zum Mietpreis eines Terminals der 1970er Jahre. Der Preis musste seinerzeit monatlich erneut bezahlt werden.

zurück zu: Erreichte Ziele

Die Tastaturen von Computern hatten so ziemlich alle schlechten Eigenschaften ihrer Vorgänger, der Schreibmaschinentastaturen, geerbt. So auch ihre Bauhöhe, die etwa bei 10 cm lag. Während es bei der Schreibmaschine hierfür einen Grund gab, konnte man auch bei intensivster Suche keine Begründung für die Bauhöhe der Tastatur für Computer finden. Die Menschen passten entweder überhaupt nicht in den Beinraum ihrer Tische oder sie quetschten sich unter den Tisch und knickten ihr Handgelenk ein. Dass man etwas tun müsste, war frühzeitig klar. Die Frage war, was?

Die Tastaturen von Computern hatten so ziemlich alle schlechten Eigenschaften ihrer Vorgänger, der Schreibmaschinentastaturen, geerbt. So auch ihre Bauhöhe, die etwa bei 10 cm lag. Während es bei der Schreibmaschine hierfür einen Grund gab, konnte man auch bei intensivster Suche keine Begründung für die Bauhöhe der Tastatur für Computer finden. Die Menschen passten entweder überhaupt nicht in den Beinraum ihrer Tische oder sie quetschten sich unter den Tisch und knickten ihr Handgelenk ein. Dass man etwas tun müsste, war frühzeitig klar. Die Frage war, was?

Büromöbelhersteller schlugen für Bildschirmbenutzer die vorhandenen Schreibmaschinentische vor. Die waren nämlich so niedrig, dass man den Arm nicht höher anheben musste. Allerdings hätten nur 20% der Deutschen unter diese Tische gepasst. Andere bauten die Tastaturen in die Tische ein, was damit verbunden war, dass man nur in einer Haltung damit arbeiten konnte. Wer möchte sich von einer Tastatur seine Haltung vorgeben lassen? Und wie lange am Tag …

Die Lösung wurde schon 1975 beim Forschungsprojekt des Bundesministers für Arbeit und Sozialordnung gefunden: … mehr Da sich Menschen körperlich nicht ändern können, müssen sich die Tastaturen ändern. Bei unserem ersten Auftrag von der Industrie wurde unwiderlegbar belegt, dass dies technisch möglich war. Der Kunde hat die flache Tastatur gebaut. Seitdem ist die Tastatur sogar flacher geworden, als wir haben damals verlangen können. Und das, obwohl die US-amerikanische Industrie mehrere Studien vorgelegt hat, dass eine flache Tastatur die Leistung der Benutzer gemindert und ihre Belastung erhöht würde. Heute gibt es Laptops, deren Höhe insgesamt gegen 10 mm tendiert.

Die flache Tastatur hat eine steile Karriere hingelegt. Die wurde zum Standard, obwohl die Norm, die sie fordern sollte, noch nicht einmal veröffentlicht war.

Etwa 15 Jahre später haben Mediziner bestätigt, dass die geknickte Haltung des Handgelenks eine Ursache für das sog. CTS = carpal tunnel syndrome ist. Zur Zeit der Untersuchung hieß das Problem noch Sehnenscheidenentzündung. Später bevorzugte man den Begriff RSI = repetitive strain injury. Wie man es auch nennt: Wenn man schon Menschen zwingt, ständig die gleichen Bewegungen auszuführen, sollte man ihre Haltung so wenig wie möglich erzwingen.

zurück zu: Erreichte Ziele

Computerbildschirme der zweiten Generation zeigten auf einem mehr oder weniger schwarzen Hintergrund eine grüne Schrift. Dahinter steckte keine besondere Weisheit. Vielmehr konnte man seinerzeit nur einen grün leuchtenden Leuchtstoff benutzen. Ein heller grüner Hintergrund hätte zudem den Effekt nur verstärkt, der zum ersten Disput mit den Gewerkschaften geführt hatte: Zwei Wiener Professoren hatten 1975 experimentell festgestellt, dass Computerbenutzer nach der Arbeit den Schnee der Alpen rosa erlebten. Daraus folgerte man, dass die Arbeit am Bildschirm täglich nicht über vier Stunden gehen durfte. Auf dieser Basis gab es bis etwa 1985 Betriebsvereinbarungen, die das Arbeiten mit dem Computer auf vier Stunden täglich begrenzten.

Der Effekt ist keine Ermüdung und auch keine Schädigung, sondern die übliche Reaktion des Auges auf vorherrschende Farben. Es adaptiert sich an diese und verschiebt somit seinen „Weißpunkt“. Wenn statt der Schrift der Hintergrund grün gewesen wäre, hätte die Umstimmung schneller erfolgen müssen. Dann etwa die Arbeit am Computer auf täglich zwei Stunden kürzen? Die Frage stellte sich nicht, weil die Geräte noch einen weiteren Mangel hatten. Sie konnten nur mit der Netzfrequenz betrieben werden, also 50 Hz in Europa und 60 Hz in den USA. Nach den damaligen Vorstellungen der Wissenschaft waren sie zwar flimmerfrei. Aber kein Benutzer würde sich vor ein solches Gerät setzen. Also betrieb man die Geräte mit negativem Kontrast, daher der Name Negativdarstellung. Das übliche Papier stellt die Schrift auf weißem Hintergrund dar. Diese Darstellung heißt dann positiv.

Aus heutiger Sicht wird sich kaum jemand mehr für Bildschirme in Negativdarstellung interessieren. Als der helle Bildschirmhintergrund ins Gespräch gebracht wurde, war die einhellige Meinung der Computerhersteller, dass dies nicht nur überflüssig sei, sondern auch die Technologie durch Kostensteigerungen in ihrer Entwicklung so weit behindern würde, dass große Gefahr drohe. Man hat nicht nur Gutachten bestellt, die diese Meinung belegen sollten, sondern auch noch versucht, Gutachten in Zweifel zu ziehen, die man selber in Auftrag gegeben hatte. Bis in die 1990er Jahre hinein versuchte mancher Hersteller nachzuweisen, dass die Negativdarstellung genauso gut war. Dass jeder Mensch mit einem Blick sehen konnte, dass dies nicht stimmt, weil die Bildschirme stärker reflektieren, ficht die Leute nicht an.

Die Positivdarstellung wurde bereits im Jahr 1976 durch Dr. Cakir als die einzig richtige nachgewiesen, und dies mit folgender Begründung:

• Ein heller Bildschirmuntergrund erhöht die Leistungsfähigkeit des Auges.

• Unvermeidbare Reflexionen wirken sich weniger störend aus, wenn der Untergrund hell ist.

• Menschen möchten lieber in einer hellen Umwelt arbeiten. Dazu müssen alle größeren Teile der Umwelt hell sein.

• Bildschirme sollten möglichst die Qualität von bedrucktem Papier aufweisen.

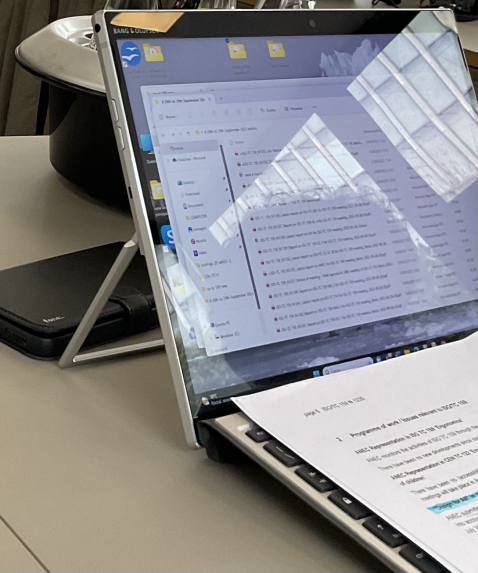

Leider konnte man solche Bildschirme seinerzeit nur im Labor simulieren. Das war der Grund des Widerstandes seitens der Hersteller. Die Technik wurde erst im Jahre 1983 einigermaßen reif. Damals führte die Firma Apple mit dem Macintosh Betriebssystem auch die Positivdarstellung ein. Die letzte Hürde wurde mit Windows 3.1 im Jahre 1992 beseitigt, die von der Software aufgestellte Hürde. Monitore mit einem scharfen und flimmerfreien Bild wurden allerdings erst im 21. Jahrhundert alltäglich. Auf Bildschirme mit der Abbildungsqualität von Papier müssen wir noch lange warten (s. Bild unten, von einem der besten Displays am Markt. Der Bildschirm ist nur in einer Position störungsfrei, das Papier praktisch in jeder Beobachtungsrichtung) . Selbst das vielgelobte e-Paper bedarf einer Weiterentwicklung, bis der Ersatz von Papier (fast) perfekt ist. Allerdings kann man heute praktisch jeden LCD-Monitor von der Stange kaufen und ihn selbst bei Tageslicht auf dem Balkon betreiben. Zwar sieht er etwa so blass aus wie die Monitore der 1970er Jahre, aber man kann in jedem Büro mit angemessener Beleuchtung solche Displays problemlos betreiben.

Der bisherige Erfolg ist zum einen den Berufsgenossenschaften zu verdanken, die eine Forderung nach Positivdarstellung bereits 1980 aufgestellt haben, und andererseits unzähligen Sicherheitsingenieuren, Betriebs- und Personalräten und Betriebsärzten, die jahrelang hierfür gekämpft haben.

Ein Vermutstropfen: Die obigen Aussagen gelten für übliche Büroaufgaben, bei denen die Farbe eine untergeordnete Rolle spielt, auch bei Excel-Anwendungen in Farbe. Bei CAD-Anwendungen hingegen, bei denen man eventuell dünne farbige Striche identifizieren können muss, kann die Negativdarstellung immer noch unverzichtbar sein. Und die härtesten Anforderungen and Displays stellen medizinische Anwendungen und Bildbearbeitung. Für medizinische Anwendung wird häufig die Benutzungsumgebung (Beleuchtung, Lichtfarbe, Leuchtdichten etc.) vorgeschrieben. Bei der Bearbeitung von Bildern mit hoher Dynamik (HDR-Fotos) ist es leider ratsam, besser im Dunkeln zu arbeiten.

zurück zu: Erreichte Ziele

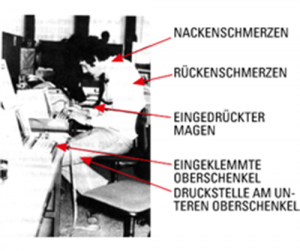

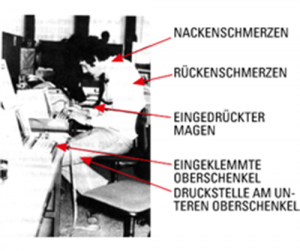

Bildschirmarbeitsplätze im Büro wurden in den 70er Jahren nach ihren Vorgängern gestaltet, an denen militärische Radarlotsen gesessen hatten. Diese waren junge Männer mit ausgesucht gutem Sehvermögen, die nur eine Sehaufgabe hatten, den Radarschirm zu beobachten. Die Sehentfernung an ihren Arbeitsplätzen wurde allerdings nach uralten Vorstellungen der Augenmedizin bestimmt – 330 mm wie beim Lesen eines Buches mit angewinkeltem Arm. Dass diese nicht einmal bei der Küchenarbeit richtig war, störte wenig.

Bildschirmarbeitsplätze im Büro wurden in den 70er Jahren nach ihren Vorgängern gestaltet, an denen militärische Radarlotsen gesessen hatten. Diese waren junge Männer mit ausgesucht gutem Sehvermögen, die nur eine Sehaufgabe hatten, den Radarschirm zu beobachten. Die Sehentfernung an ihren Arbeitsplätzen wurde allerdings nach uralten Vorstellungen der Augenmedizin bestimmt – 330 mm wie beim Lesen eines Buches mit angewinkeltem Arm. Dass diese nicht einmal bei der Küchenarbeit richtig war, störte wenig.

Menschen im Büro haben andere Aufgaben, sie sind im Durchschnitt viel älter und haben mindestens zur Hälfte kein ausreichendes Sehvermögen. Auch nach sorgfältiger Korrektur der Augen weist etwa jeder dritte Mensch unentdeckte visuelle Probleme auf. Was passiert, wenn der Arbeitsplatz falsch gestaltet ist?

Dieses Bild, das in unzähligen Variationen auch im Internet kursiert, hat alle Skeptiker überzeugt. In Deutschland wurde eine neue Sehentfernung für Arbeitsplätze festgelegt. Diese beträgt 500 mm. Zu gering für Sehphysiologen, die lieber viel größere Sehentfernungen vorsehen würden. Auf absehbare Zeit wird dies ein Traum für die meisten Menschen auf der Welt bleiben: Selbst im Land der unbegrenzten Möglichkeiten sind die Arbeitsplätze so klein, dass die Sehentfernung ungesund begrenzt verbleiben wird. Nach der neuesten Norm für die Gestaltung von Bildschirmarbeitsplätzen sollte sie 600 mm betragen, und der Benutzer soll sie um 150 mm nach vorn oder hinten ändern können. Diese scheinbar unwichtige Größen bestimmen mit, welcher Prozentsatz der Büromitarbeiter jährlich den Orthopäden aufsuchen müssen. Die „neueste“ Norm ist mittlerweile ein Vierteljahrhundert alt.

Dieses Bild, das in unzähligen Variationen auch im Internet kursiert, hat alle Skeptiker überzeugt. In Deutschland wurde eine neue Sehentfernung für Arbeitsplätze festgelegt. Diese beträgt 500 mm. Zu gering für Sehphysiologen, die lieber viel größere Sehentfernungen vorsehen würden. Auf absehbare Zeit wird dies ein Traum für die meisten Menschen auf der Welt bleiben: Selbst im Land der unbegrenzten Möglichkeiten sind die Arbeitsplätze so klein, dass die Sehentfernung ungesund begrenzt verbleiben wird. Nach der neuesten Norm für die Gestaltung von Bildschirmarbeitsplätzen sollte sie 600 mm betragen, und der Benutzer soll sie um 150 mm nach vorn oder hinten ändern können. Diese scheinbar unwichtige Größen bestimmen mit, welcher Prozentsatz der Büromitarbeiter jährlich den Orthopäden aufsuchen müssen. Die „neueste“ Norm ist mittlerweile ein Vierteljahrhundert alt.

Das Bild lieferte übrigens die Vorlage für eine allseits bekannte Darstellung der Evolution des Menschen.

Das Bild lieferte übrigens die Vorlage für eine allseits bekannte Darstellung der Evolution des Menschen.

Flexible Möbel?

In einer Phase der Geschichte, in der die Welt wie die Arbeitswelt auch größten Veränderungen unterworfen waren, blieb die Geschichte der Büromöbel merkwürdigerweise wenig verändert. Die DIN-Norm für Arbeitstische von 1936 wurde erst im Jahre 1968 (!) gründlich überarbeitet. Selbst dann änderte sich relativ wenig. Alle Tische hatten vier Ecken und vier Beine, zwischen denen mehr oder weniger Platz für die Beine des Benutzers war – je nach Stellung in der Firma. Diejenigen, die fast den ganzen Tag an der Schreibmaschine verbrachten, hatten nicht nur die kleinsten, sondern auch die niedrigsten Tische. Man wähnte sich vor den Unbilden der Technisierung geschützt, die die Produktionsstätten längst erfasst hatte, und war doch der Technik ausgeliefert: Die Form der Tische bestimmte die Technik der Säge. Genau gesagt, der Bandsäge, daher die viereckige Form der Tische.

Mit dem Einmarsch der Computer änderte sich das Bild des Büros. Die einen blieben ihren Vierbeinern, Farbe eiche hell, treu, während andere auf eigene Faust experimentierten. Unsere Untersuchungen aus den 70er Jahren, die die „beste“ Gestaltung für den Bildschirm-Arbeitsplatz finden helfen sollten, ergaben ein unerwartetes Ergebnis: Trotz intensiver Suche in 30 Betrieben konnte der beste Bildschirmtisch nicht gefunden und genormt werden.

Trotzdem wurde genormt: Das Arbeitsmöbel sollte flexibel sein, d.h. der Hersteller des Möbels durfte nicht festlegen, wie es benutzt wird. Dazu musste man allerdings die Hersteller von Bildschirmgeräten zwingen, ihre Tastaturen vom Bildschirm zu trennen und so flach zu machen, dass man sie beliebig auf dem Tisch platzieren kann. Dass beide Ziele erreicht wurden, ist der Arbeit der Berufsgenossenschaften und des DIN zu verdanken. Heute gibt es nicht einmal mehr feste Möbelgrößen, sondern eine Minimalgröße, die man bei Bedarf um jeweils 20 cm erweitern kann.

Das Konzept ist einfach zu beschreiben, war aber sehr schwierig durchzusetzen. Es besteht darin, dass jeder einzelne Benutzer in der Lage sein muss, die Anordnung seiner Arbeitsmittel selbst zu bestimmen und bei Bedarf zu ändern, und zwar möglichst einfach ohne Werkzeug. Hierzu wird eine Arbeitsplatte benötigt, die alle Arbeitsmittel aufnehmen kann und so dünn ist, dass sie bei allen Menschen beim Sitzen zwischen Unterarm und Oberschenkel passt.

Die Umsetzung konnte nur nach Überwindung der wichtigsten Hindernisse gelingen. Diese waren nicht nur das Design der Bildschirmgeräte (unhandlich, zu groß, Tastaturen zu hoch und mit dem Bildschirm verbunden) und konstruktive Eigenschaften der Möbel (Material Holz, Stabilität, Schubladen im Beinraum etc.). Das allergrößte Hindernis bestand in der Dimensionierung der Arbeitsräume. Denn Bürohäuser wurden, anders als Wohngebäude, mit bestimmten Rastermaßen gebaut (z.B. 1,20 m, 1,25 m, 1,80 m). So kann ein Arbeitsraum in der Breite wie in der Tiefe jeweils ein Vielfaches des Rastermaßes aufweisen (z.B. 3 x 1,20 m = 3,60 m). Während frühere Büromöbel aus heutiger Sicht „krumme“ Größen wie 1,56 m in der Breite und 0,70 m in der Tiefe aufwiesen, passten die moderneren „Bildschirmmöbel“ mit Abmessungen von 0,80 m oder gar 1,0 m in der Tiefe und bis zu 2,0 m in der Breite nicht in diese Raster hinein. Diese Zeiten sind allerdings für die meisten Büros vorbei. Heute kann man an einem früher üblichen Schreibtisch bis drei große Bildschirme parallel betreiben, wenn es Sinn macht.

Das Konzept des flexiblen Arbeitsplatzes hat sich derart selbstverständlich durchgesetzt, dass Menschen, denen man es erläutert fragen, wozu man denn ein Konzept gebraucht hat, es sei eben so.

zurück zu: Erreichte Ziele

Die heute europaweit gesetzlich eingeführten Vorsorgeuntersuchungen (§ 6 Bildschirmarbeitsverordnung, Untersuchung der Augen und des Sehvermögens) gehen auf Untersuchungen von Dr. Çakir in den 70er Jahren zurück (s. Çakir, A.; Reuter, H.-J.; Schmude, L.v.; u.a.: Anpassung von Bildschirmarbeitsplätzen an die physische und psychische Funktionsweise des Menschen, BM für Arbeit und Sozialordnung, Bonn, 1978). Sie wurden zum ersten Mal zwischen den Arbeitsgebern in der Druckindustrie und der (ehemaligen) Gewerkschaft IG Druck und Papier bzw. dem Deutschen Journalistenverband nach einem langen Streik vereinbart. Dieser Streik war im Übrigen der erste Konflikt, bei dem es hauptsächlich um Themen wie Arbeitsqualität und Arbeitsplatzgestaltung ging.

Die Idee wurde international ins Gespräch gebracht durch das Buch „The VDT Manual“ (s. Çakir, Hart, Stewart, 1979). Das Buch enthielt bereits zu diesem Zeitpunkt einen vollständig ausgearbeiteten Sehtest, der mit den seinerzeit führenden Augenärzten in Europa abgesprochen worden war.

In Deutschland wurde die Idee einer Vorsorgeuntersuchung für Bildschirmarbeiter vom Fachausschuss Verwaltung des Hauptverbandes der gewerblichen Berufsgenossenschaften aufgegriffen, der eine bessere Lösung als nur die Prüfung des Sehvermögens beschloss. (s. Berufsgenossenschaftlicher Grundsatz für arbeitsmedizinische Vorsorgeuntersuchungen „Bildschirm-Arbeitsplätze“, G37) Dieser Grundsatz sah Folgendes vor:

„Das Sehvermögen von Beschäftigten an Bildschirm-Arbeitsplätzen ist von einem ermächtigten Arzt überprüfen zu lassen. Die Erstuntersuchung hat vor Aufnahme der Tätigkeit zu erfolgen. Nachuntersuchungen sind in 5jährigem Abstand, bei Personen über 45 Jahre in 3jährigem Abstand vorzunehmen.“ An der Erstellung dieses Grundsatzes war unser Institut maßgeblich beteiligt.

Mit der Europäischen Arbeitsschutzrichtlinie 90/270 (Bildschirmrichtlinie) wurden die Vorsorgeuntersuchungen in ganz Europa gesetzlich vorgeschrieben. Leider blieb die Lösung hinter der viel älteren Lösung der Berufsgenossenschaften zurück, weil sie nur das Sehvermögen berücksichtigt.

Heute ist die Vorsorge für das Sehvermögen Teil der „Verordnung zur arbeitsmedizinischen Vorsorge (ArbMedVV)“ :

(2) Angebotsvorsorge bei:

1. Tätigkeiten an Bildschirmgeräten

Die Angebotsvorsorge enthält das Angebot auf eine angemessene Untersuchung der Augen und des Sehvermögens. Erweist sich auf Grund der Angebotsvorsorge eine augenärztliche Untersuchung als erforderlich, so ist diese zu ermöglichen. § 5 Abs. 2 gilt entsprechend für Sehbeschwerden. Den Beschäftigten sind im erforderlichen Umfang spezielle Sehhilfen für ihre Arbeit an Bildschirmgeräten zur Verfügung zu stellen, wenn Ergebnis der Angebotsvorsorge ist, dass spezielle Sehhilfen notwendig und normale Sehhilfen nicht geeignet sind; …“

zurück zu: Erreichte Ziele

Das Usability Konzept wurde in einem Projekt für Software-Ergonomie niedergeschrieben. Es lässt sich aber vorzüglich auf Konsumgüter anwenden. Designer von Alltagsgegenständen haben das Konzept sinngemäß angewendet, noch bevor es genormt wurde. Leider geschah dies eher intuitiv denn methodisch. Dies führt zum einen dazu, dass der Hersteller wenig von erfolglosen Produkten lernt. Und zum anderen, dass manchmal erfolgreiche Produkte verschlimmbessert werden, weil man häufig nicht weiß, weswegen ein Produkt erfolgreich geworden ist.

Das Usability Konzept wurde in einem Projekt für Software-Ergonomie niedergeschrieben. Es lässt sich aber vorzüglich auf Konsumgüter anwenden. Designer von Alltagsgegenständen haben das Konzept sinngemäß angewendet, noch bevor es genormt wurde. Leider geschah dies eher intuitiv denn methodisch. Dies führt zum einen dazu, dass der Hersteller wenig von erfolglosen Produkten lernt. Und zum anderen, dass manchmal erfolgreiche Produkte verschlimmbessert werden, weil man häufig nicht weiß, weswegen ein Produkt erfolgreich geworden ist. Die historisch älteste Form der künstlichen Beleuchtung sollte möglichst aus dem Gedächtnis der arbeitenden Menschen verschwinden. Man hatte etwa 1970 das seit mehr als 40 Jahren angestrebte Ziel erreicht, alle Arbeitsstätten gleichmäßig zu beleuchten – egal ob deren Benutzer dies wollten oder nicht. „Allgemeinbeleuchtung erhöht die Leistungsfähigkeit des Arbeiters“ hatte es zu Beginn des vergangenen Jahrhunderts geheißen. Zu dessen Ende glaubten die meisten Lichttechniker immer noch daran, auch wenn der Nachweis niemandem gelingen wollte.

Die historisch älteste Form der künstlichen Beleuchtung sollte möglichst aus dem Gedächtnis der arbeitenden Menschen verschwinden. Man hatte etwa 1970 das seit mehr als 40 Jahren angestrebte Ziel erreicht, alle Arbeitsstätten gleichmäßig zu beleuchten – egal ob deren Benutzer dies wollten oder nicht. „Allgemeinbeleuchtung erhöht die Leistungsfähigkeit des Arbeiters“ hatte es zu Beginn des vergangenen Jahrhunderts geheißen. Zu dessen Ende glaubten die meisten Lichttechniker immer noch daran, auch wenn der Nachweis niemandem gelingen wollte. Während die übliche Tischlampe ihr Licht schlecht kontrolliert in die Umgebung streut, leuchtet die Arbeitsplatzleuchte nach DIN 5035-8 den vom Benutzer gewünschten Teil aus, schont aber die Augen des Tischnachbarn ebenso wie den Bildschirm, auf dem sie keine Reflexionen verursachen darf. DIN 5035-8 steht auch als Beispiel dafür, wie man durch Normung Individualität schafft und das auch in engen Arbeitsräumen.

Während die übliche Tischlampe ihr Licht schlecht kontrolliert in die Umgebung streut, leuchtet die Arbeitsplatzleuchte nach DIN 5035-8 den vom Benutzer gewünschten Teil aus, schont aber die Augen des Tischnachbarn ebenso wie den Bildschirm, auf dem sie keine Reflexionen verursachen darf. DIN 5035-8 steht auch als Beispiel dafür, wie man durch Normung Individualität schafft und das auch in engen Arbeitsräumen. Die vom Präsidenten Jimmy Carter angeordnete Überprüfung US-amerikanischer Kernkraftwerke nach der Katastrophe von Three Mile Island hatte noch katastrophalere Mängel in der Ergonomie an den Tag gefördert, die den Unfall verursacht hatten. Die Kraftwerke in den USA wurden eiligst „ertüchtigt“. In anderen Ländern haben die Regierungen gewisse Auflagen an die Betreiber gemacht, aber mit zunehmender Entfernung vom Ort des Geschehens nahm die Bereitschaft ab, sich von der Vorstellung zu befreien, „so etwas kann bei uns nicht passieren“. Und das, obwohl in Three Mile Island fünf Vorfälle mit einer Wahrscheinlichkeit von jeweils 1/10.000 Jahren gleichzeitig aufgetreten waren. D.h., dass dieser Unfall theoretisch eine Wahrscheinlichkeit von einer Billion Jahren hatte. Da das Universum nur wenige Milliarden Jahre alt ist, hätte der Unfall eigentlich nicht passieren dürfen.

Die vom Präsidenten Jimmy Carter angeordnete Überprüfung US-amerikanischer Kernkraftwerke nach der Katastrophe von Three Mile Island hatte noch katastrophalere Mängel in der Ergonomie an den Tag gefördert, die den Unfall verursacht hatten. Die Kraftwerke in den USA wurden eiligst „ertüchtigt“. In anderen Ländern haben die Regierungen gewisse Auflagen an die Betreiber gemacht, aber mit zunehmender Entfernung vom Ort des Geschehens nahm die Bereitschaft ab, sich von der Vorstellung zu befreien, „so etwas kann bei uns nicht passieren“. Und das, obwohl in Three Mile Island fünf Vorfälle mit einer Wahrscheinlichkeit von jeweils 1/10.000 Jahren gleichzeitig aufgetreten waren. D.h., dass dieser Unfall theoretisch eine Wahrscheinlichkeit von einer Billion Jahren hatte. Da das Universum nur wenige Milliarden Jahre alt ist, hätte der Unfall eigentlich nicht passieren dürfen. Das Forschungsprojekt „Arbeitsplätze für Phonotypistinnen“, veröffentlicht im Jahre 1983, hat neben vielen anderen Erkenntnissen ein sich unglaubwürdig anmutendes Ergebnis erbracht: Die harmlos aussehenden Diktiergeräte erzeugten Lärmpegel, die sich mit denen von Düsenjägern messen lassen. Das Ergebnis klang deswegen so unglaubwürdig, weil die Geräte mittlerweile über 80 Jahre im Einsatz waren und niemand sich darüber beschwert haben sollte. Zudem musste man in Zweifel ziehen, ob eine Elektronik mit einem geringen Energieverbrauch solche Lärmpegel hätte überhaupt erzeugen könnte.

Das Forschungsprojekt „Arbeitsplätze für Phonotypistinnen“, veröffentlicht im Jahre 1983, hat neben vielen anderen Erkenntnissen ein sich unglaubwürdig anmutendes Ergebnis erbracht: Die harmlos aussehenden Diktiergeräte erzeugten Lärmpegel, die sich mit denen von Düsenjägern messen lassen. Das Ergebnis klang deswegen so unglaubwürdig, weil die Geräte mittlerweile über 80 Jahre im Einsatz waren und niemand sich darüber beschwert haben sollte. Zudem musste man in Zweifel ziehen, ob eine Elektronik mit einem geringen Energieverbrauch solche Lärmpegel hätte überhaupt erzeugen könnte. Hersteller versuchen, den Kunden an sich zu binden, indem sie Produkte möglichst so konstruieren, dass Ersatzteile von anderen Herstellern nicht dazu passen. Die Idee ist nicht neu – und die Aussage stammt aus einem Buch von 1926, das die Gründung des DIN rechtfertigt. Trotzdem muss man sich auch heute solchen Versuchen erwehren. Die Welt hat sich verändert, bestimmte Praktiken sind geblieben.

Hersteller versuchen, den Kunden an sich zu binden, indem sie Produkte möglichst so konstruieren, dass Ersatzteile von anderen Herstellern nicht dazu passen. Die Idee ist nicht neu – und die Aussage stammt aus einem Buch von 1926, das die Gründung des DIN rechtfertigt. Trotzdem muss man sich auch heute solchen Versuchen erwehren. Die Welt hat sich verändert, bestimmte Praktiken sind geblieben. Die Tastaturen von Computern hatten so ziemlich alle schlechten Eigenschaften ihrer Vorgänger, der Schreibmaschinentastaturen, geerbt. So auch ihre Bauhöhe, die etwa bei 10 cm lag. Während es bei der Schreibmaschine hierfür einen Grund gab, konnte man auch bei intensivster Suche keine Begründung für die Bauhöhe der Tastatur für Computer finden. Die Menschen passten entweder überhaupt nicht in den Beinraum ihrer Tische oder sie quetschten sich unter den Tisch und knickten ihr Handgelenk ein. Dass man etwas tun müsste, war frühzeitig klar. Die Frage war, was?

Die Tastaturen von Computern hatten so ziemlich alle schlechten Eigenschaften ihrer Vorgänger, der Schreibmaschinentastaturen, geerbt. So auch ihre Bauhöhe, die etwa bei 10 cm lag. Während es bei der Schreibmaschine hierfür einen Grund gab, konnte man auch bei intensivster Suche keine Begründung für die Bauhöhe der Tastatur für Computer finden. Die Menschen passten entweder überhaupt nicht in den Beinraum ihrer Tische oder sie quetschten sich unter den Tisch und knickten ihr Handgelenk ein. Dass man etwas tun müsste, war frühzeitig klar. Die Frage war, was?

Bildschirmarbeitsplätze im Büro wurden in den 70er Jahren nach ihren Vorgängern gestaltet, an denen militärische Radarlotsen gesessen hatten. Diese waren junge Männer mit ausgesucht gutem Sehvermögen, die nur eine Sehaufgabe hatten, den Radarschirm zu beobachten. Die Sehentfernung an ihren Arbeitsplätzen wurde allerdings nach uralten Vorstellungen der Augenmedizin bestimmt – 330 mm wie beim Lesen eines Buches mit angewinkeltem Arm. Dass diese nicht einmal bei der Küchenarbeit richtig war, störte wenig.

Bildschirmarbeitsplätze im Büro wurden in den 70er Jahren nach ihren Vorgängern gestaltet, an denen militärische Radarlotsen gesessen hatten. Diese waren junge Männer mit ausgesucht gutem Sehvermögen, die nur eine Sehaufgabe hatten, den Radarschirm zu beobachten. Die Sehentfernung an ihren Arbeitsplätzen wurde allerdings nach uralten Vorstellungen der Augenmedizin bestimmt – 330 mm wie beim Lesen eines Buches mit angewinkeltem Arm. Dass diese nicht einmal bei der Küchenarbeit richtig war, störte wenig. Dieses Bild, das in unzähligen Variationen auch im Internet kursiert, hat alle Skeptiker überzeugt. In Deutschland wurde eine neue Sehentfernung für Arbeitsplätze festgelegt. Diese beträgt 500 mm. Zu gering für Sehphysiologen, die lieber viel größere Sehentfernungen vorsehen würden. Auf absehbare Zeit wird dies ein Traum für die meisten Menschen auf der Welt bleiben: Selbst im Land der unbegrenzten Möglichkeiten sind die Arbeitsplätze so klein, dass die Sehentfernung ungesund begrenzt verbleiben wird. Nach der neuesten Norm für die Gestaltung von Bildschirmarbeitsplätzen sollte sie 600 mm betragen, und der Benutzer soll sie um 150 mm nach vorn oder hinten ändern können. Diese scheinbar unwichtige Größen bestimmen mit, welcher Prozentsatz der Büromitarbeiter jährlich den Orthopäden aufsuchen müssen. Die „neueste“ Norm ist mittlerweile ein Vierteljahrhundert alt.

Dieses Bild, das in unzähligen Variationen auch im Internet kursiert, hat alle Skeptiker überzeugt. In Deutschland wurde eine neue Sehentfernung für Arbeitsplätze festgelegt. Diese beträgt 500 mm. Zu gering für Sehphysiologen, die lieber viel größere Sehentfernungen vorsehen würden. Auf absehbare Zeit wird dies ein Traum für die meisten Menschen auf der Welt bleiben: Selbst im Land der unbegrenzten Möglichkeiten sind die Arbeitsplätze so klein, dass die Sehentfernung ungesund begrenzt verbleiben wird. Nach der neuesten Norm für die Gestaltung von Bildschirmarbeitsplätzen sollte sie 600 mm betragen, und der Benutzer soll sie um 150 mm nach vorn oder hinten ändern können. Diese scheinbar unwichtige Größen bestimmen mit, welcher Prozentsatz der Büromitarbeiter jährlich den Orthopäden aufsuchen müssen. Die „neueste“ Norm ist mittlerweile ein Vierteljahrhundert alt. Das Bild lieferte übrigens die Vorlage für eine allseits bekannte Darstellung der Evolution des Menschen.

Das Bild lieferte übrigens die Vorlage für eine allseits bekannte Darstellung der Evolution des Menschen.